22Ney44

Membre association-

Compteur de contenus

4038 -

Inscription

-

Dernière visite

-

Jours gagnés

13

Type de contenu

Profils

Forums

Téléchargements

Blogs

Boutique

Calendrier

Noctua

Tout ce qui a été posté par 22Ney44

-

Bonjour @Bart Simpson Oui vous vous trompe-je ! L'univers se dilate de manière isotrope dans tout son volume connu. Le voyage de retour depuis la Lune en 1969 par exemple était un femto-pouième de quart de poil plus long qu'à l'aller, et ce sera encore le cas la prochaine fois. Ney

-

Notre nouvel ami, fort discret au demeurant doit être un fan de manga. En effet dans le manga Naruto, "Orochimaru" (pris comme pseudo par l'auteur de ce sujet) est l'un des trois ninjas connus sous le nom de "Sannin". Vous découvrirez alors que l'un des buts recherchés par "Orochimaru" est de devenir immortel, ce qu'il arrive à faire en partie en changeant régulièrement de corps. D'où l'idée pour l'auteur de ce sujet, qui veut peut-être devenir immortel aussi, de se faire greffer un bout d'hydre. Mais bon @'Bruno l'a bien mis en garde de ne pas se tromper dans la manip, sinon c'est dur dur pour l'éternité. Un truc par exemple, il va devoir cotiser des millions d'années pour la retraite sans jamais pouvoir la prendre. Hé oui il n'atteindra jamais l'âge légal du départ ... Le voilà condamné à obéir pour l'éternité au chef, car trop jeune il ne montera jamais non plus en grade. C'est long l'éternité vous savez, très très long surtout vers la fin ... Ney

-

Quelques images rigolotes ou étranges... bis !

22Ney44 a répondu à un sujet de RIGEL33 dans On fait une pause

C'est marrant, à réécouter ce superbe sketch, ça fait dans ma tête le même bruit que celui que faisait en amphi du lundi matin à 8H00, le cours de Thermo-Stat ! 🤢 Allez savoir pourquoi ? Ney -

Bonjour @Bart Simpson, La lumière se déplace à 300 000 km/s. Nous pouvons considérer actuellement cette valeur comme un invariant absolu et infranchissable. Pour le reste ce qui suit est sous couvert du modèle de Physique qui a actuellement cours. Pour un engin terrestre dans au moins deux sauts techniques majeurs (ICI une idée de situations hautement spéculatives et non démontrées techniquement) nous atteindrons peut-être 1% de cette vitesse soit donc 3 000 km/s. A cette vitesse et à condition d'y aller par le chemin le plus court il nous faudra déjà 400 ans pour rejoindre l'étoile la plus proche. Pour atteindre Andromède il faudrait 250 millions d'années juste pour l'aller et nous sommes encore en local au regard des dimensions de l'Univers. De plus, plus nous voudrons aller loin, moins nous le pourrons parce que confrontés à la dilatation de l'espace. Notre objectif s'éloignera de nous plus vite que notre vitesse maximum, ce d'autant plus qu'il est éloigné. Voyager de galaxies en galaxies est certes très poétique mais très inaccessible avec le modèle standard de notre Physique à ce jour, quelque soit la perspective que vous preniez pour aborder le voyage. Le processus le plus crédible serait peut-être l'intrication quantique, mais vous savez comme moi que dans ce cas il n'y a pas voyage de la matière, il y a "recopie" de l'objet de départ au point d'arrivée. Si cela marche en laboratoire avec une particule élémentaire (elles sont chacune dans leur famille parfaitement identiques entre elles, ce qui facilite incommensurablement le processus), serez-vous candidat pour vous faire recopier au point d'arrivée avec disparition de l'original au point de départ ? Notre Galaxie fait entre 100 et 120 000 années lumière de diamètre, il nous faudrait alors pour seulement la traverser environ 10 à 12 millions d'années. Concernant la vie carbonnée nous savons à quoi nous en tenir. Concernant la vie robotique, du moins celle que nous connaissons à base de semi-conducteur une telle durée de voyage conduirait inéluctablement à la dégénérescence prévisible de la matière silicée. Cette dégénérescence aura deux origines connues à ce jour : 1) Le silicium seul est inerte comme le carbone seul. Ce que nous savons faire pour l'instant ce sont des semi-conducteurs en dopant les monocristaux en réseau de Bravais par une substance "désiquilibrant" les charges électriques. Ce résultat s'obtient en diffusant à haute température le dopant dans le monocristal. Pour obtenir un cristal Négatif les dopants possible sont l'arsenic, l'antimoine ou encore le phosphore. Un cristal positif s'obtient avec de l'aluminium, du bore ou du gallium. Sur la durée de vie actuelle du cristal devenu composant électronique, soit environ 100 à 500 ans, cette structure est considérée comme stable. Sur un million d'années le substrat aura évolué de manière telle que les fonctions implantées dans le substrat auront disparues ou seront très fortement dégradées car le réseau cristallin aura continué d'évoluer spontanément. 2) Le bombardement permanent par les rayonnements cosmiques de toute nature aura également eu raison de l'arrangement cristallin. C'était le sujet d'une thèse de l'un de mes fils, réalisée à l'Université William&Mary en Virginie pour le compte de la NASA. En 2003 le voyage aller/retour Mars, pour lequel contribuait son travail, posait déjà des problèmes théoriques insolubles dès que la gravure des composants passait sous un certain seuil pourtant absolument nécessaire à une intégration suffisante pour obtenir la puissance de calcul. Tout ceci pour vous dire que même une forme de vie très rudimentaire basée sur le silicium n'a pas d'horizon de viabilité raisonnable pour des voyages galactiques, même s'il est significativement supérieur à celui du carbone. Ney

-

Bonjour @'Bruno, A tout le monde ! Ney

-

Intéressant en effet , tout au moins pour moi. Pourtant les constructeurs utilisent de plus en plus la géobiologie et la Pneumatit pour "protéger" l'environnement des éoliennes. @xs_man as-tu un lien qui m'enverrait sur ce sujet des vaches mortes? Bonjour @polorider, Un peu de lecture : https://viapl.fr/avec-les-eoliennes-les-vaches-meurent-et-les-humains-sont-malades/ Ney

-

Bonjour les gens, C'est curieux tout de même les périodes pourtant très proches dans le temps qui font modifier le comportement des personnes vis à vis de la dette. Lorsqu'il s'agissait de percevoir son salaire intégral durant les confinements où rien n'était demandé en échange, ou encore maintenant quand il s'agit d'encaisser la prime d'État pour lutter contre les bouleversements climatiques et le réchauffement de l'atmosphère comme "ma prime Renov' ", qui se soucie alors de refuser ces offres au motif qu'elles vont aggraver la dette. Rester cohérent dans son comportement lorsqu'on porte un avis négatif sur la dette devrait pourtant faire adopter ces refus sans réfléchir davantage et être alors fondé à porter un jugement critique sur ceux et celles qui ne le font pas. En acceptant à titre individuel tous ces versements, la moindre des choses est d'accepter sans broncher les conséquences qui les accompagne. JDCJDR, Modération oblige ! Ney

-

Quizz alternatif convivial: la résurrection

22Ney44 a répondu à un sujet de chatbleu54 dans Quizz, Jeux, détente

Bonjour @pat59, Ben si, un peu quand même ! Elle était juste posée sur le porte bagage de la fusée. Ney -

Quizz alternatif convivial: la résurrection

22Ney44 a répondu à un sujet de chatbleu54 dans Quizz, Jeux, détente

Pas sûr ! Je porte encore une tignasse SEL&poivre longue et très dense. Ce n'est donc pas ça. Ney -

Quizz alternatif convivial: la résurrection

22Ney44 a répondu à un sujet de chatbleu54 dans Quizz, Jeux, détente

Ben si ! Il y a Armageddon en 1998. Ney -

Quizz alternatif convivial: la résurrection

22Ney44 a répondu à un sujet de chatbleu54 dans Quizz, Jeux, détente

Bonjour les gens, Souvenez-vous de la mission DART qui est venu volontairement percuter Dimorphos satellite de l'astéroïde Didymos, afin de modifier sa trajectoire. Si nous y sommes parvenus une fois, avec l'expérience acquise, on doit pouvoir reproduire il me semble. Quelqu'un connaitrait-il la dead line de lancement d'une telle mission pour qu'elle réussisse ? Ney -

Bonsoir @xs_man, Ce que vous dites est très intéressant. Pourriez-vous indiquer où et comment le GIEC a filtré les modèles climatiques dont il a fait la compilation pour ne faire ressortir à coup sûr que le scénario du réchauffement ? Tant que vous y serez, donnez-moi un lien vers un modèle climatique validé par les pairs, rejeté par le GIEC, qui montre un climat stable à moyen et long terme. Avec cela vous allez me convaincre de revoir ma position., et je pourrai à mon tour critiquer durement le GIEC pour m'avoir trompé. Ney

-

Bonsoir @marco44, Vous avez tout à fait raison. L'exemple qui me vient à l'instant en matière de biodiversité est la pollinisation par les abeilles. On ne comptabilise dans ce processus que les abeilles domestiques. Or elles ne sont responsables que de 15 à 20 % de la pollinisation, le reste est essentiellement dû aux abeilles et assimilés sauvages pour qui aucune mesure de protection n'est prise. Intéressez-vous au nombre faramineux de brevets déposés depuis longtemps par Monsanto pour protéger sa conception des nano-drones pollinisateurs. Plus vite les abeilles sauvages auront disparues, plus vite il pourra mettre ses drones sur le marché. Je vous laisse imaginer le rapport de force qui va s'engager avec les États à l'avantage de Monsanto : "Vous payez ou vous n'aurez pas de pollinisation, donc vos populations ne mangeront plus". Va y avoir du "sport". Une fois encore, au risque de me répéter, sans nourriture les premiers problèmes arrivent dès le troisième jour même pour les climato- négationnistes/réalistes/septiques. Ney

-

Bonjour les gens, Plusieurs fois, j'ai fait ici allusion au risque de rupture alimentaire pour la population, comme conséquence des bouleversements climatiques qui s'annoncent. Aux causes climatiques il semble qu'il faille aussi additionner certaines causes politiques et/ou financières. Voici le lien vers le récent Rapport de Terre de Liens . C'est peut-être à savoir au moment des choix cruciaux. Ney

-

Hum !!!! Ney

-

Bonjour le gens, "Bonne" nouvelle pour la France ! Cette fois nous sommes en tête sur le plan mondial. Une prospective du gouvernement basée sur une étude Météo France indique que, par rapport à l'ère pré-industrielle, en 2030 nous serons à +2,0°C alors que la Planète ne sera qu'à +1,5°C, en 2050 nous serons à +2,7°C pour +2°C pour la Planète et enfin en 2100 nous serons à +4°C lorsque la Planète n'en sera "qu'à" +3°C. Connaissant de plus la légendaire "prudence" de l'Administration, ces chiffres sont vraisemblablement édulcorés. La vraie bonne nouvelle est que nous savons au moins que l'Administration est au courant. Les politiciens/iennes en place le sont-ils/elles tout autant ? Là j'ai des doutes raisonnables. Un ancien ministre récent, pourtant impliqué dans l'environnement, avec qui je déjeunais, ignorais l'implication du méthane sur le climat par exemple, seul le CO2 lui était connu ... No comment ! Bonne lecture du rapport MTO. Ney

-

Bonsoir @VNA, Oui c'est tout à fait normal. Puisque le terme "Valley" est passé dans le langage courant en France concernant ce lieu, il est normal que le mot précédent demeure aussi américain soit "silicon" (américain) pour "silicium" (français). Sinon l'expression eût été "Vallée du silicium" pour conserver le français intégral. Voili, voilou. Ney

-

Bonsoir @Kristophe, L'expression "négationniste" n'est en rien une insulte, c'est une caractéristique qui ne fait par ailleurs l'objet d'aucune ambiguïté. Il y a en France suite à la publication d'une étude de l'ADEME que j'ai citée précédemment environ 28% de négationnistes climatiques dont, il ne fait plus aucun doute, vous appartenez à cette frange de la population. Ces 28% de personnes ne se déclarent pas insultées par le reste de la population, à part vous ici. Personne ne vous affuble de quoi que ce soit. Aussi je vous serais reconnaissant de bien vouloir cesser d'(ab)user de cette rhétorique qui voudrait que vous soyez continuellement insulté afin que vous puissiez justifier de vos manières, pour le moins constatées à pratiquement chacune de vos interventions, de nous insulter. Employez plutôt votre précieux temps à nous répondre par des arguments construits, étayés, illustrés et qui sait, peut-être arriverez-vous à nous convaincre que les bouleversements climatiques déjà mesurés et à venir n'ont aucune origine anthropique, seulement des phénomènes rien de plus naturels. Il vous faudra être très convaincant, je vous l'accorde. Nous vous avons posé de nombreuses questions et sauf erreur de ma part, vous n'avez répondu à aucune. Tenez la dernière posée, je vous demandais de montrer où dans les écrits de ce sujet vous aviez été insulté, puisque là aussi vous prétendiez l'avoir été copieusement (sic). Votre silence à ce sujet, masqué par une grande agitation verbale, serait-il la reconnaissance de votre mensonge et de votre tentative de manipulation ? A vous lire Ney

-

Pourquoi le verrouillage de la face visible de la lune?

22Ney44 a répondu à un sujet de Bart Simpson dans Astronomie & Astrophysique

Bonjour @Bart Simpson, Merci tout d'abord pour vos compliments, c'est très élégant de votre part. Pour répondre à votre dernière question, "astram" est un néologisme né de la contraction de l'expression "Astronome amateur", c'est tout simple. Un dernier mot : Dans vos recherche de lecture, attachez-vous à étudier également la notion de conservation du moment angulaire autre appellation du moment cinétique. Les moteurs de recherche pointent un peu différemment. Cette appellation ouvre davantage sur des explications mathématiques et conduisent vers l'abstraction du phénomène. Ney -

Pourquoi le verrouillage de la face visible de la lune?

22Ney44 a répondu à un sujet de Bart Simpson dans Astronomie & Astrophysique

Bonjour @Bart Simpson, Pour la Terre et la Lune c'est exactement la même chose. Le système Terre/Lune est un système lié où la Terre serait le corps et les bras seraient la Lune liés au corps. En vous relisant attentivement j'essaie de saisir votre schéma mental de compréhension de la situation. Lorsque vous vous interrogez sur l'éventuelle chute de la Lune sur la Terre par exemple j'entraperçois que peut-être il y a confusion de définition entre gravitation et pesanteur. La pesanteur est une conséquence de la gravitation, mais vous pouvez vous trouver en situation d'apesanteur bien qu'étant toujours soumis à la gravitation. C'est le cas lorsque vous êtes en orbite où en vol parabolique (dit vol 0G) à bord d'un avion. Ce sont deux notions physiques différentes que je vous invite à approfondir avant d'aller plus loin. Essayez en particulier de bien mentaliser ce que physiquement représente la déformation de l'espace/temps au voisinage d'une masse. Vous allez ainsi franchir une étape dans le degré d'abstraction et admettre que le lien Terre/Lune est autre qu'un lien matériel concrètement palpable, autre qu'un "bâton" pour une "pichenette". Pour l'instant je ne peux guère faire mieux que de vous inviter à creuser en ce sens. Peut-être un autre astram rompu à l'enseignement de la physique saura-t-il vous éclairer. Bonne recherche. Ney -

Quelques images rigolotes ou étranges... bis !

22Ney44 a répondu à un sujet de RIGEL33 dans On fait une pause

Belle Fête de Saint Valentin à toutes les amoureuses et tous les amoureux. Veuille le Ciel que Cupidon se mette à l’œuvre pour toutes et tous les autres. Ney -

Pourquoi le verrouillage de la face visible de la lune?

22Ney44 a répondu à un sujet de Bart Simpson dans Astronomie & Astrophysique

Ils n'en auront pas le temps en l'état actuel du système solaire. Sachez que comme l'a rappelé @rmor51 les orbites planétaires sont chaotiques (au sens mathématique du terme). Aussi tirer des plans sur la comète me semble plutôt hasardeux. Si vous souhaitez vous lancer dans la prospective, je vous invite à étudier en profondeur les travaux de Jacques LASKAR, [ https://perso.imcce.fr/jacques-laskar/en/ ]pionnier de la "mathématisation" des orbites planétaires du système solaire (mais pas que cela, cet homme est un chercheur éclectique, ce qui ne gâte rien). Pour l'instant nous avons raisonné sur un système à deux corps, la Terre et la Lune. La décroissance du moment cinétique de la Terre ne concerne donc que la rotation sur elle-même, ce qui explique l'allongement incessant de sa durée de rotation et donc des jours. Si vous souhaitez introduire le Soleil dans la réflexion, nous passons alors à un système à trois corps. Dans ce cas, à part des conditions initiales très particulières, il n'existe pas de solutions analytiques pour décrire le phénomène. Il nous reste seulement les outils de simulation. Je vous renvoie à nouveau sur les travaux de Jacques LASKAR pour lesquels je n'ai pas suffisamment de connaissances pour les comprendre et encore moins pour les expliquer. Édit Cependant pour autant que je le sache, la vitesse de rotation de la Terre autour du Soleil ne varie pas pour des raisons gravitationnelles. Elle varie seulement en raison de la deuxième loi de Kepler, la loi des aires. Ceci veut dire que les valeurs extrêmes de cette vitesse sont constantes. La valeur moyenne est de 29,78 km/s soit 107 200 km/h. La terre parcourt ainsi son diamètre équatorial en environ 7 mn et 8s Ney -

Pourquoi le verrouillage de la face visible de la lune?

22Ney44 a répondu à un sujet de Bart Simpson dans Astronomie & Astrophysique

Bonjour @Bart Simpson, Là vous avez décrit ce qui est observé et validé. La Lune s'écarte de nous au rythme actuel d'environ 3,8 cm /an. Elle le fait car comme vous le dites, elle reçoit une "pichenette" d'ailleurs permanente. Quelle est donc la nature de cette impulsion ? Le phénomène initial est celui des marées engendrées par la gravitation. Ce fait est observable depuis des milliards d'années. La Lune (le Soleil aussi mais oublions le) par effet de gravitation attire l'eau des océans jusqu'à former un bourrelet. Vous avez certainement noté que la marée n'est pas haute lorsque la Lune est au zénith. Ceci est dû au fait que la Terre continue de tourner sur elle-même.plus vite que la Lune autour de la Terre. A cause de la force gravitationnelle de la Terre sur ses masses liquides, les océans restent (heureusement pour nous) en place et suivent la Terre. En devançant la Lune, il y a alors compétition entre la force d'attraction terrestre et la force d'attraction lunaire sur nos océans. De cette lutte gravitationnelle nait sur Terre des forces de frictions Sol/Masse liquide qui en réclamant leur énergie prise à la Terre ralentissent cette dernière dans sa rotation sur elle-même son orbite. Or en Physique à deux corps (mais pas que) il y a un principe fondamental qui est celui de la conservation du moment cinétique (cours assez complet sur le moment cinétique pour faire chauffer le neurone). Le couple Terre/Lune n'y échappe pas. Donc si le moment cinétique de la Terre décroit, celui de la Lune augmente. La voilà la "pichenette" qui conduit la Lune à s'éloigner de nous. Cet éloignement est inexorable. Il est alors possible de calculer (mais je vous épargne les calculs qui n'apporteraient que peu à l'explication de l'éloignement) le temps où nous atteindrons le verrouillage gravitationnel des deux astres. Tous calculs faits cela prendra environ 50 milliards d'années. Vous l'avez compris, toute chose par ailleurs égales (ici la remarque faite ci-dessus par @rmor51 prend toute sa valeur) nous ne connaitrons jamais ce verrouillage puisque dans 5 milliards d'années les carottes seront cuites (au sens propre comme au sens figuré) pour le système solaire. Il y aura par contre des conséquences visibles pour les générations lointaines qui nous succéderont (si toutefois l'espèce humaine aura initié sa propre conservation, ce qui n'est actuellement pas gagné avec les conséquences du CO2 dans l'atmosphère c'est ici dans WebAstro ). Il n'y aura plus d'éclipses totales du Soleil mais seulement des éclipses annulaires car le diamètre apparent de la Lune sera plus faible que celui du Soleil du fait de son éloignement croissant. Il y a d'autres conséquences moins perceptibles. Les jours allongent tout aussi inéluctablement de 1,8 millisecondes par siècle, ce qui tous calculs faits demandera 3, 3 millions d'années pour augmenter de ... une minute. Voili voilou pour la "pichenette". Ney -

Quizz alternatif convivial: la résurrection

22Ney44 a répondu à un sujet de chatbleu54 dans Quizz, Jeux, détente

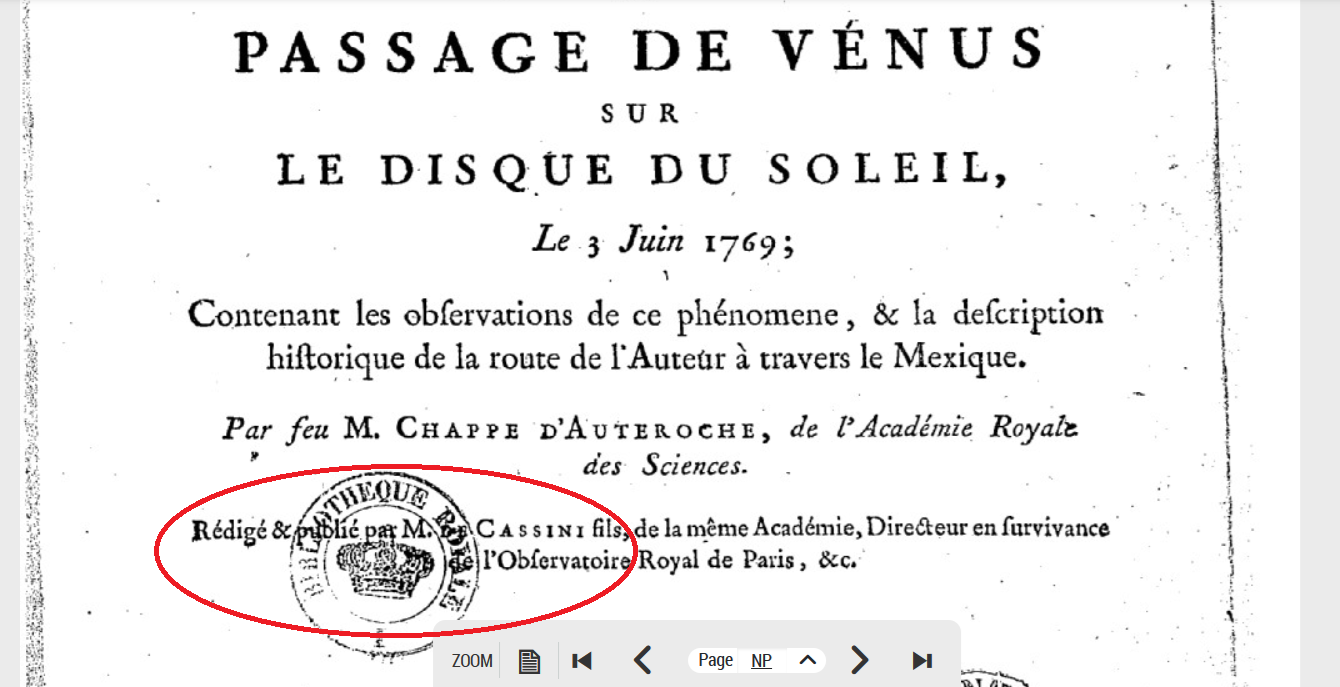

Bonjour @roger15, L'énigme dans son questionnement était très délicate à répondre. En effet par exemple pour la question 2 vous demandiez : et vous apportez comme réponse : en appuyant votre réponse par le lien vers le livre publié en 1772 Or ce livre n'a pas été rédigé par l'Abbé Chappe d'Auteroche mais par M. de CASSINI lui-même Directeur de l'Observatoire de Paris. Voici la preuve : C'est pourquoi, parce que je supputais que vous attendiez la réponse "Jean CHAPPE" comme auteur et surtout observateur et chef de mission, que j'ai cité non pas ce livre de Cassini rédigé depuis les notes de CHAPPE, mais les notes manuscrites relles-mêmes conservées en 6 tomes à l'Observatoire de Paris. Pour la personne qui a rapporté les instruments et les notes, je m'en suis tenu au lien que vous proposez vous-même Vous écrivez : Dans le lien que vous proposez il est écrit : La note 8 au bas de l'article dit ceci : Dans ses notes, puis plus tard dans le livre écrit par Cassini il est tout à fait possible qu'on lise que c'est l'ingénieur PAULY qui a rapporté les instruments et notes. Et cela est normal. Encore en vie c'est à cet ingénieur que CHAPPE aurait confié ses biens. Ce que l'on sait c'est que c'est bien DUHAMEL de MONCEAU seul survivant de la mission qui les a remis à l'Académie des Sciences. Qu'était devenu l'ingénieur PAULY ? Je n'ai rien trouvé à cet égard. Voilà ce ne sont pas des preuves formelles que je vous apporte, mais seulement des informations puisées dans les références que vous avez données. Ai-je répondu à votre attente ? Ney -

Quizz alternatif convivial: la résurrection

22Ney44 a répondu à un sujet de chatbleu54 dans Quizz, Jeux, détente

Bonjour @roger15, Manuscrit du "Journal du Voyage de Jean CHAPPE en Californie", vraisemblablement le Tome 1 sur 6 puisque nous en sommes au départ de l'expédition. Ces manuscrits sont conservés à la Bibliothèque de l'Observatoire de Paris. Je pense qu'il s'agit de l'Abbé Jean Chappe d'Auteroche, oncle de Claude Chappe inventeur du télégraphe Chappe. Deux voyages espacés de huit ans pour un astronome à la recherche d'un événement rare, ressemble très fort à l'observation de Vénus en transit devant le Soleil, la première fois en Sibérie, la seconde en Basse Californie au Mexique actuel où il a trépassé en août 1769 à 41 ans. Il n'y eut qu'un seul survivant de cette expédition, un certain Duhamel du Monceau qui put ainsi rapporter à la fois les instruments mais surtout les compte-rendus d'observations. Ney